Klicken Sie hier zur Registrierung und zum Download der Daten

Herzlich Willkommen auf der Homepage der DENSE Datensätze

Das EU-Projekt DENSE hat zum Ziel eines der herausforderndsten Probleme des automatisierten Fahrens zu lösen: die Umgebung unter allen Wetterbedingungen zu erfassen. Schlechtes Wetter - wie z.B. Schnee, starker Regen oder Nebel - stellt eine der letzten noch verbleibenden technischen Herausforderungen dar, die die Markteinführung des selbstfahrenden Autos derzeit noch verhindern. Diese Herausforderung kann nur durch eine neue Technologie zur Umgebungserfassung gelöst werden, die zu jeder Zeit und unter jeder Wetterbedingung zuverlässig arbeitet.

Diese Homepage präsentiert eine Vielzahl von Projekten und Datensätzen, die während des Projekts entwickelt wurden.

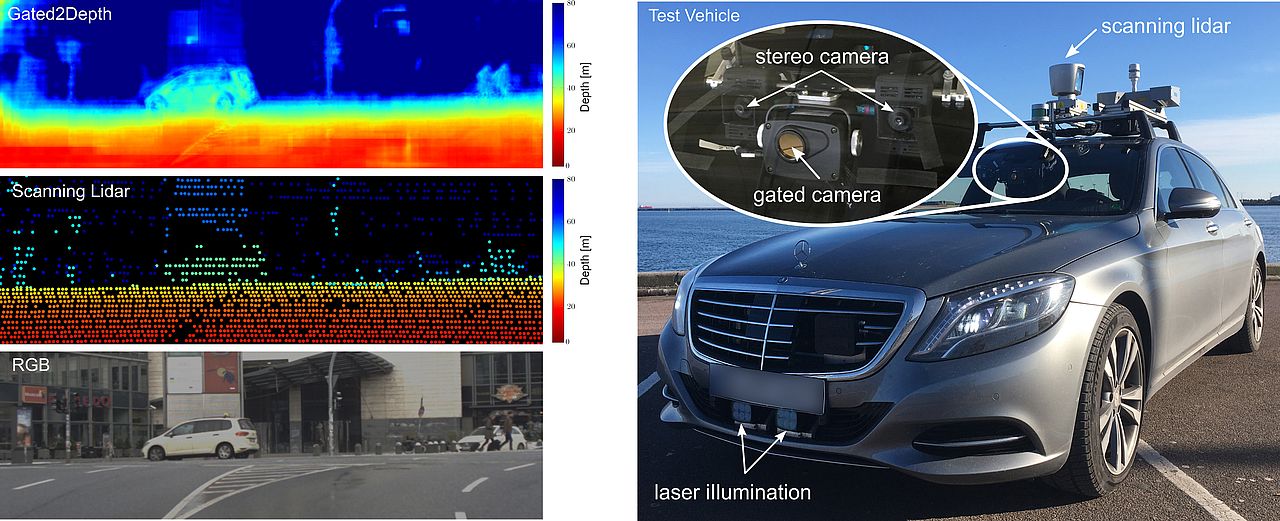

- Gated2Depth: Bildgebende Methode, die aus drei Bildern einer Gated-Kamera eine hochauflösende Tiefenkarte erzeugt. Die Tiefengenauigkeit ist dabei mit Lidar-Messungen vergleichbar.

- Seeing Through Fog: Neuer multimodaler Datensatz mit 12.000 Szenen unter verschiedenen Wetter- und Beleuchtungsbedingungen und 1.500 Messungen in einer Nebelkammer. Zudem ist der Datensatz mit genauen menschlichen Labels für Objekte, die mit 2D- und 3D-Bounding-Boxen anmontiert wurden, und Frame-Tags, welche das Wetter, die Tageszeit und die Straßenbedingungen beschreiben, versehen.

- Gated2Gated: Selbst überwachtes Framework, welches aus drei unterschiedlich beleuchteten Bildern einer Gated Kamera absolute Tiefenkarten erzeugt und zyklische und zeitliche Konsistenz als Trainingssignal verwendet. Diese Arbeit erweitert den Seeing Through Fog-Datensatz um zeitlich aufeinanderfolgende Gated Sequenzen. Dabei enthält jedes zentrale Gated-Bild synchronisierte Lidar-Daten und präzise Szenen- und Objektannotationen.

- Pixel Accurate Depth Benchmark: Ein Benchmark für Methoden zur 3D-Umgebungserfassung unter verschiedenen Wetterbedingungen mit hochauflösender Tiefe.

- Image Enhancement Benchmark: Ein Benchmark für Bildverbesserungsmethoden.

Wir stellen ein bildgebendes Framework vor, das drei Bilder einer kostengünstigen CMOS-Gated-Kamera in hochauflösende Tiefenkarten umwandelt, deren Tiefengenauigkeit mit gepulsten Lidar-Messungen vergleichbar ist. Die wichtigsten Beiträge dieser Arbeit sind:

- Ein lernbasierten Ansatz zur Schätzung von hochauflösender Tiefe aus Bildern einer Gated Kamera, ohne dass dichte Tiefeninformation beim Training benötigt wird.

- Validierung der vorgeschlagene Methode in der Simulation und an realen Messungen, die mit einem Prototypensystem in anspruchsvollen und realen Straßenszenarien aufgezeichnet wurden. Wir zeigen, dass die Methode eine dichte Tiefeninformation von bis zu 80m extrahieren kann und die Tiefengenauigkeit dabei mit einem scannenden Lidar vergleichbar ist.

- Datensatz: Wir stellen den ersten großen Datensatz mit Bildern einer Gated Kamera zur Verfügung, der bei Testfahrten (über 4.000km) in Nordeuropa aufgezeichnet wurde.

Nutzung der Daten

Tools zur Nutzung des Datensatzes stehen in Python zur Verfügung. Zusätzlich ist das Modell in Tensorflow verfügbar.

Klicken Sie hier!

Zitat

Wenn Sie unsere Arbeit zur Tiefenschätzung mit Gated Bildern interessant finden, zitieren Sie bitte unsere Publikation:

@inproceedings{gated2depth2019,

title = {Gated2Depth: Real-Time Dense Lidar From Gated Images},

author = {Gruber, Tobias and Julca-Aguilar, Frank and Bijelic, Mario and Heide, Felix},

booktitle = {The IEEE International Conference on Computer Vision (ICCV)},

year = {2019}

}

Wir stellen einen Datensatz zur Objekterkennung unter schwierigen Witterungsbedingungen vor, der 12000 Proben in realen Fahrszenen und 1500 Beispiele unter kontrollierten Wetterbedingungen in einer Nebelkammer umfasst. Der Datensatz beinhaltet verschiedene Wetterbedingungen wie Nebel, Schnee und Regen und wurde bei mehreren insgesamt über 10.000 km langen Fahrten in Nordeuropa gesammelt. Die gefahrene Strecke mit Städten entlang der Straße ist rechts dargestellt. Insgesamt wurden 100k Objekte mit genauen 2D- und 3D-Bounding-Boxen annotiert. Die wichtigsten Beiträge dieses Datensatzes sind:

- Wir stellen ein Testgelände für eine breite Palette von Algorithmen zur Verfügung. Speziell werden Methoden der Signalverbesserung, Domänenanpassung, Objekterkennung oder multimodale Sensorfusion abgedeckt.

- Durch die Multimodalität eignet sich der Datensatz für das Lernen robuster Redundanzen zwischen Sensoren, insbesondere wenn diese bei unterschiedlichen Wetterbedingungen asymmetrisch ausfallen.

- In unserem Fall haben wir eine adaptive Fusion angewendet, die durch die Messung der Entropie angetrieben wird und die Detektion auch im Falle unbekannter negativer Wettereffekte ermöglicht. Diese Methode übertrifft andere Referenzfusionsmethoden, die sogar unter Einzelbildmethoden fallen.

- Weitere Informationen können in unserer Publikation hier gefunden werden.

Videos

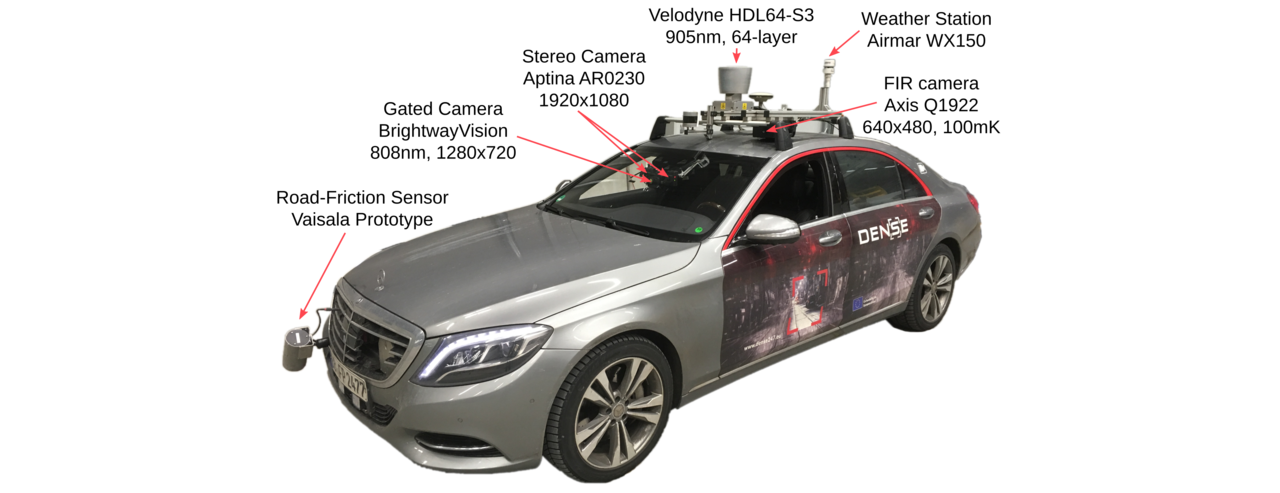

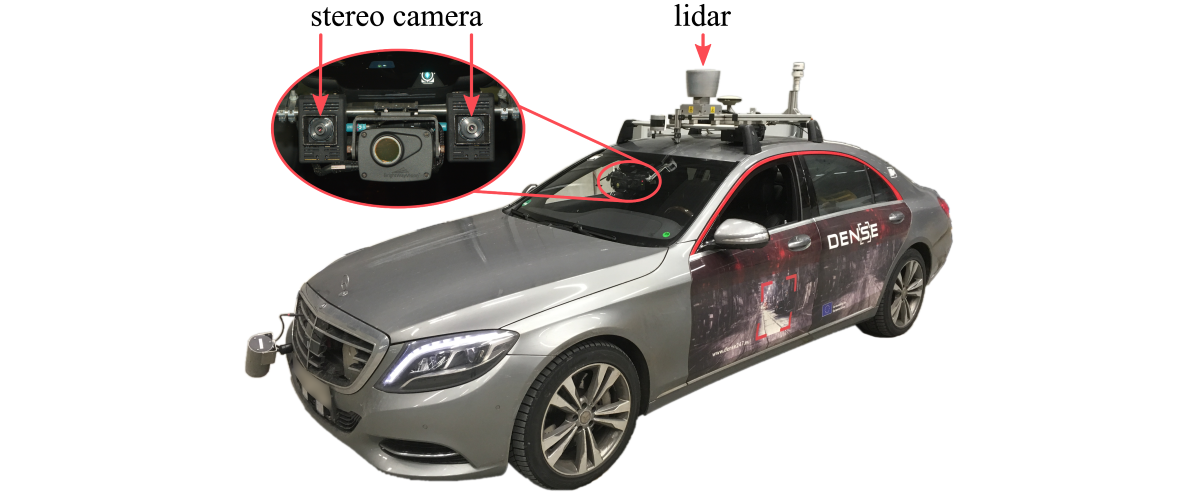

Sensor-Setup

Zur Erfassung des Datensatzes haben wir das unten dargestellte Testfahrzeug mit Sensoren aufgebaut. Die Sensorik deckt die das sichtbare-, NIR-, FIR- und mm-Spektrum ab. Insgesamt messen wir die Intensitäten, Tiefe und Wetterbedingungen. Weitere Informationen finden Sie in unserem Datensatzpapier.

Nutzung des Datensatzes

Wir stellen dokumentierten Code zur Handhabung des von uns bereitgestellten Datensatzes in Python zur Verfügung.

Klicken Sie hier!

Klicken Sie hier!

Referenz

Wenn Sie unsere Arbeit zur Objektdetektion bei schlechtem Wetter für Ihre Forschung nützlich finden, würden wir uns über eine Zitation unser Arbeit freuen:

@InProceedings{Bijelic_2020_CVPR,

author = {Bijelic, Mario and Gruber, Tobias and Mannan, Fahim and Kraus, Florian and Ritter, Werner and Dietmayer, Klaus and Heide, Felix},

title = {Seeing Through Fog Without Seeing Fog: Deep Multimodal Sensor Fusion in Unseen Adverse Weather},

booktitle = {The IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR)},

month = {June},

year = {2020}

}

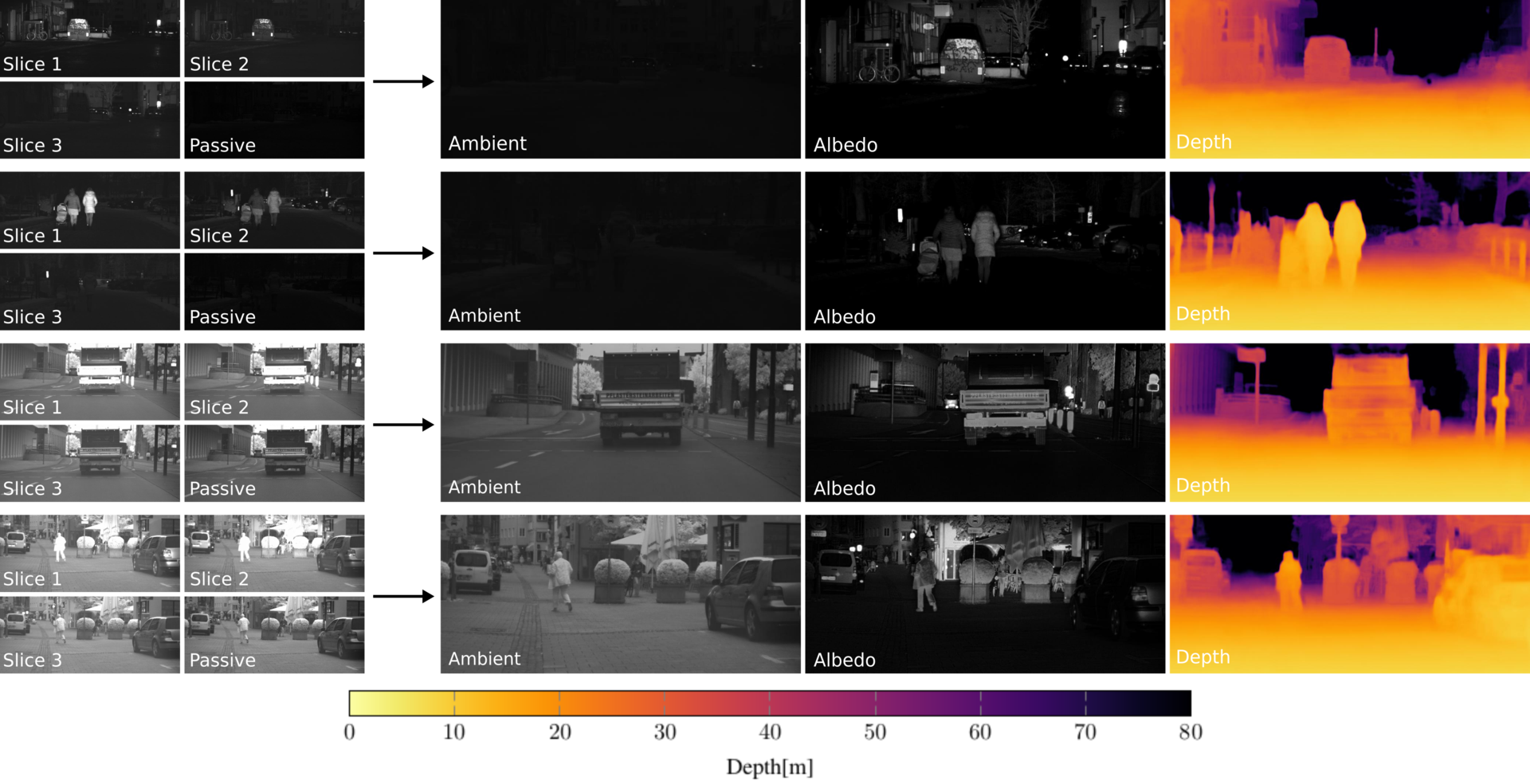

Wir stellen ein selbst überwachtes Framework vor, welches drei unterschiedlich beleuchtete Bilder von einer Gated Kamera in hochauflösende Tiefenkarten umwandelt und keine Überwachung durch einen Tiefen-Sensor benötigt. Durch die gleichzeitige Schätzung von Albedo, Tiefe und Umgebungsbeleuchtung der Szene, können die Eingangs-Gated-Bilder rekonstruiert und eine zyklische Konsistenz erzwungen werden. Dies ist in dem Titelbild dargestellt. Zusätzlich verwenden wir sequentielle Daten um eine zeitliche Konsistenz zwischen aufeinanderfolgenden Gated-Bildern herstellen zu können. Dadurch kann das Framework vollständig selbst überwacht trainiert werden. Die wichtigsten Beiträge dieser Arbeit sind:

- Wir präsentieren die erste selbst überwachte Methode zur Tiefenschätzung von Gated-Bildern, bei welcher die Tiefenprädiktionen ohne Überwachung durch einen Tiefensensor erlernt wird.

- Wir zeigen, dass die entwickelte Methode bessere Ergebnisse liefert als andere selbst überwachte und überwachte Methoden, vor allem bei Schlecht-Wetterbedingungen wie Nebel oder Schneefall, bei denen die LiDAR Messungen zu ungenau sind, um für eine Überwachung des Trainings verwendet zu werden.

- Datensatz: Wir präsentieren den ersten Datensatz für sequentielle Gated-Bilder, welcher aus etwa 130 000 Bildern besteht und sowohl bei guten als auch bei schlechten Wetterbedingungen aufgenommen wurden. Dieser Datensatz dient als Erweiterung des Seeing Through Fog-Datensatz, welcher detaillierte Szenen- und, Objektannotationen sowie entsprechende multimodale Daten enthält.

Videos

Nutzung der Daten

Tools zur Nutzung des Datensatzes stehen in Python zur Verfügung. Zusätzlich wurde das entwickelte Modell in PyTorch implementiert.

Klicken Sie hier!

Zitat

Wenn Sie unsere Arbeit zur selbstüberwachten Tiefenschätzung mit Gated Bildern interessant finden, zitieren sie bitte unsere beiden Publikation:

@article{gated2gated,

title={Gated2Gated: Self-Supervised Depth Estimation from Gated Images},

author={Walia, Amanpreet and Walz, Stefanie and Bijelic, Mario and Mannan, Fahim and Julca-Aguilar, Frank and Langer, Michael and Ritter, Werner and Heide, Felix},

journal={arXiv preprint arXiv:2112.02416},

year={2021}

}

und

@InProceedings{Bijelic_2020_CVPR,

author = {Bijelic, Mario and Gruber, Tobias and Mannan, Fahim and Kraus, Florian and Ritter, Werner and Dietmayer, Klaus and Heide, Felix},

title = {Seeing Through Fog Without Seeing Fog: Deep Multimodal Sensor Fusion in Unseen Adverse Weather},

booktitle = {The IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR)},

month = {June},

year = {2020}

}

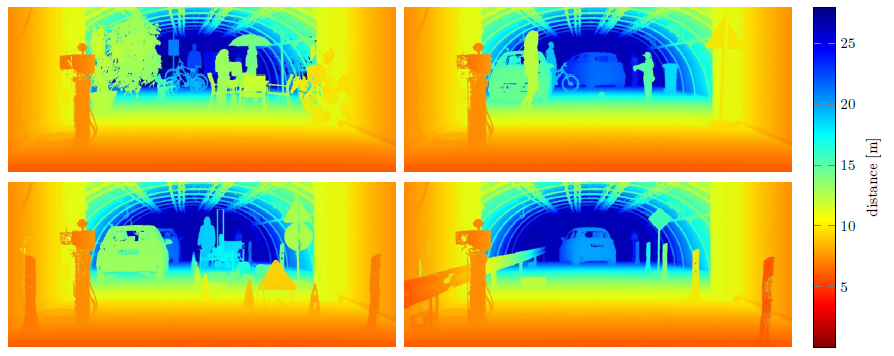

Wir führen eine Bewertungsmethodik für die 3D-Umgebungserfassung ein, die auf hochauflösenden Tiefenmessungen mit einer Winkelauflösung von bis zu 25" (Winkelsekunden) basiert. Diese Auflösung ist mit einer 50-Megapixel-Kamera vergleichbar. Die wichtigsten Beiträge dieses Benchmarks sind:

- Hochauflösende Ground Truth Tiefe: hochpräzise 3D-Messungen mit einer Winkelauflösung von 25" - das ist eine Größenordnung höher als bei vorhandenen Lidar-Datensätzen mit einer Winkelauflösung von 300".

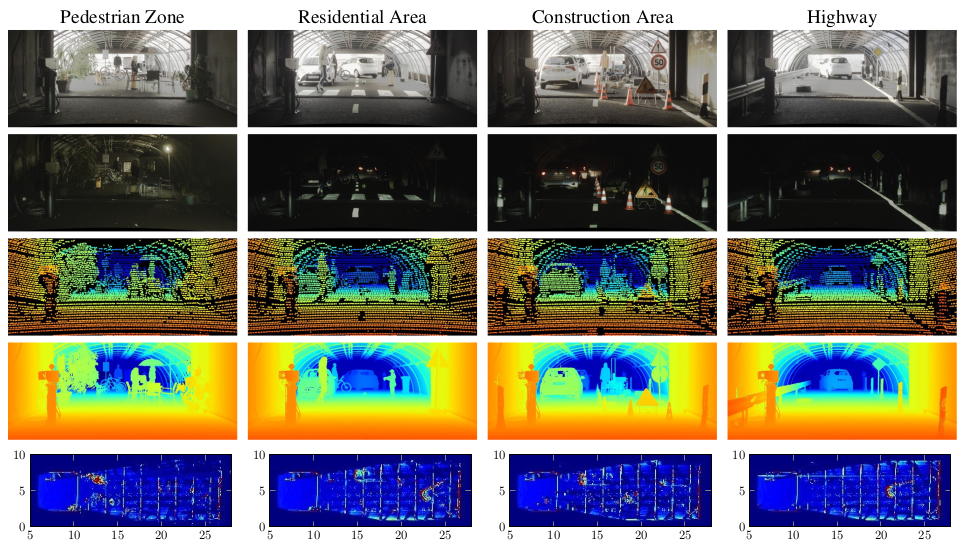

- Detaillierte Auswertungen unter definierten Bedingungen: 1.600 Bilder von vier typischen Straßenszenen, die bei definierten Wetter-(Klar, Regen, Nebel) und Beleuchtungsbedingungen (Tag, Nacht) aufgenommen wurden.

- Multimodale Sensoren: Zusätzlich zu monokularen Kamerabildern bieten wir einen kalibrierten Sensoraufbau mit einer Stereokamera und einem Lidar-Scanner.

Nutzung der Daten

Tools zur Auswertung und Visualisierung des Datensatzes (Python) stehen in unserem github-Repository zur Verfügung.

Klicken Sie hier!

Übersicht

Wir stellen vier typische Outdoor-Straßenszenarien angelehnt an den KITTI-Datensatz nach. Im Einzelnen wurden dabei die folgenden vier realistischen Szenarien aufgebaut: Fußgängerzone, Wohngebiet, Baustelle und Autobahn. Insgesamt besteht dieser Benchmark aus jeweils 10 zufällig ausgewählten Stichproben jedes Szenarios (Tag/Nacht) bei klarem Wetter, leichtem Regen, starkem Regen und 17 Sichtbarkeitsstufen bei Nebel (20-100m in 5m-Schritten), was insgesamt 1.600 Stichproben ergibt.

Sensoraufbau

Um realistische Sensordaten eines Fahrzeuges zu erhalten, die als Grundlage für die in dieser Arbeit bewerteten Methoden zur 3D-Rekonstruktion dienen, wurde ein Forschungsfahrzeug mit einer RGB-Stereokamera (Aptina AR0230, 1920x1024, 12bit) und einem Lidar (Velodyne HDL64-S3, 905 nm) ausgestattet. Alle Sensoren arbeiten in einer ROS-Umgebung und werden durch ein PPS-Signal (Pulse per Second), das von einer proprietären Inertialmesseinheit (IMU) bereitgestellt wird, zeitsynchronisiert.

Video

Zitat

Wenn Sie unsere Arbeit zur Bewertungsmethodik von Tiefenschätzungsmethoden interessant finden, zitieren Sie bitte unsere Publikation:

@inproceedings{PixelAccurateDepthBenchmark2019,

title = {Pixel-Accurate Depth Evaluation in Realistic Driving Scenarios},

author = {Gruber, Tobias and Bijelic, Mario and Heide, Felix and Ritter, Werner and Dietmayer, Klaus},

booktitle = {International Conference on 3D Vision (3DV)},

year = {2019}

}

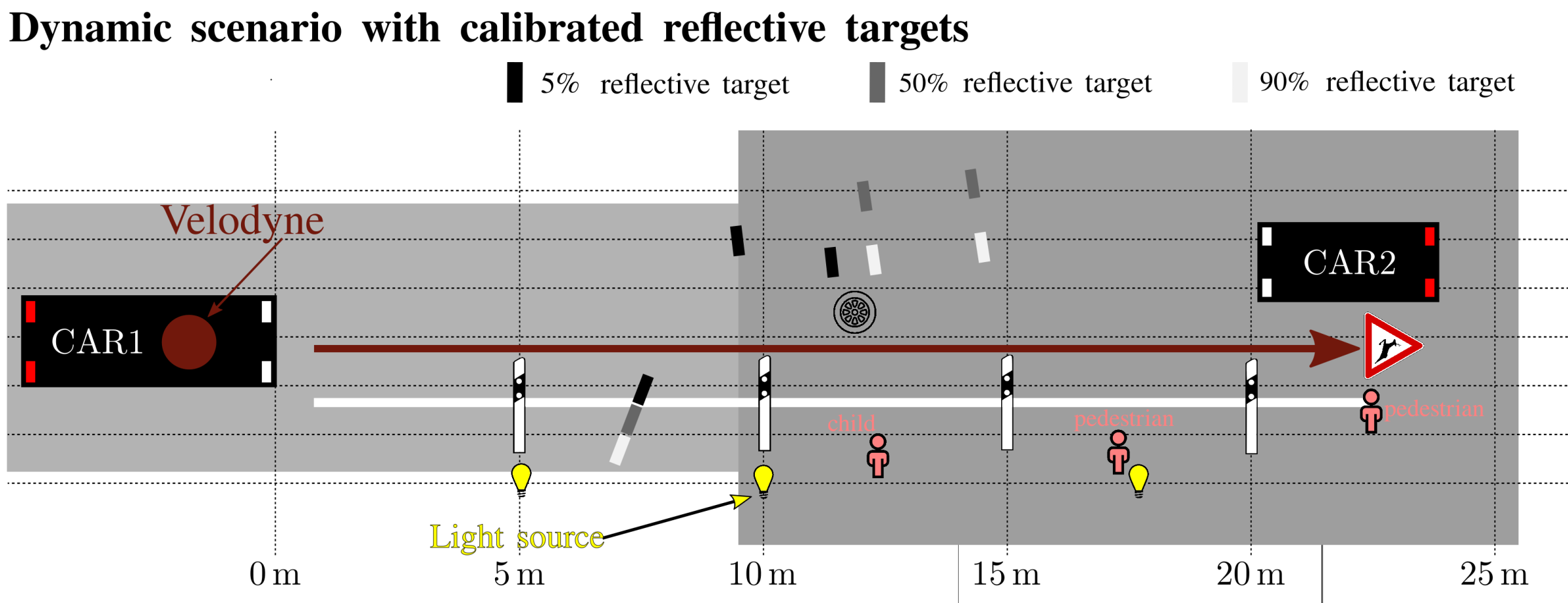

Aufgrund des schlecht gestellten Problems der Datenerfassung innerhalb von Schlechtwetterszenarien, insbesondere Nebel, basieren die meisten Ansätze im Bereich der Bildentnebelung auf synthetischen Datensätzen und Standardmetriken, die meist aus allgemeinen Ansätzen (Denoising oder Deblurring) stammen. Um die Leistung eines solchen Systems bewerten zu können, sind echte Daten und eine angemessene Metrik erforderlich. Wir stellen einen neuartigen kalibrierten Benchmark-Datensatz vor, der unter realen und definierten Wetterbedingungen aufgezeichnet wurde. Deshalb wurden bewegliche kalibrierte Targets in unterschiedlichen Entfernungen bei anspruchsvoller Beleuchtung und in kontrollierten Wetterbedingungen aufgezeichnet. Dies ermöglicht eine direkte Berechnung des Kontrasts zwischen den jeweiligen Targets und eine leicht interpretierbare Verbesserung des Ergebnisses in Bezug auf den sichtbaren Kontrast.

Zusammengefasst sind die wichtigsten Beiträge:

- Wir stellen einen neuartigen Benchmark-Datensatz zur Verfügung, der unter definierten und einstellbaren realen Wetterbedingungen aufgenommen wurde.

- Eine Metrik wird eingeführt, die die Leistung von Bildverbesserungsmethoden auf eine intuitivere und besser interpretierbare Weise beschreibt.

- Eine Vielzahl modernster Bildverbesserungsmethoden und -metriken wird auf der Grundlage unseres neuartigen Benchmark-Datensatzes untereinander verglichen.

Um den Datensatz aufzunehmen wurden 50cm x 50cm große diffusive Zenith-Polymer-Targets entlang der roten Linie unten verschoben und mit Sensoren eines Forschungsfahrzeuges in der Nebelkammer aufgezeichnet. Weitere Informationen entnehmen Sie bitte unserer Publikation. Das verwendete statische Szenario ist Teil des Pixel Accurate Depth Benchmark.

Beispielbilder

Oben zeigen wir Beispielbilder für klare Verhältnisse (links) und Nebelbilder (rechts) für eine Nebelsichtweite von 30-40m.

Zitat

Wenn Sie unsere Arbeit zur Auswertung von Algorithmen zur Bildverbesserung interessant finden, zitieren Sie bitte unsere Publikation:

@InProceedings{Bijelic_2019_CVPR_Workshops,

author = {Bijelic, Mario and Kysela, Paula and Gruber, Tobias and Ritter, Werner and Dietmayer, Klaus},

title = {Recovering the Unseen: Benchmarking the Generalization of Enhancement Methods to Real World Data in Heavy Fog},

booktitle = {The IEEE Conference on Computer Vision and Pattern Recognition (CVPR) Workshops},

month = {June},

year = {2019}

}

Community contributions

Point Cloud Denoising

Für die anspruchsvolle Aufgabe der Entrauschung von Lidar-Punktwolken werden Daten aus dem Pixel Accurate Depth Benchmark und dem Seeing Through Fog Datensatz verwendet. Diese Daten wurden unter schlechten Wetterbedingungen wie starkem Regen oder dichtem Nebel aufgezeichnet. Insbesondere werden dabei die Punktwolken von einem Velodyne VLP32c Lidar-Sensor verwendet.

Nutzung der Daten

Tools zur Visualisierung (Python) stehen in unserem github-Repository zur Verfügung:

Klicken Sie hier!

Zitat

Wenn Sie unsere Arbeit zur Entrauschung von Lidar-Punktwolken bei ungünstigem Wetter für Ihre Forschung nützlich finden, zitieren Sie bitte unsere Publikation:

@article{PointCloudDeNoising2019,

author = {Heinzler, Robin and Piewak, Florian and Schindler, Philipp and Stork, Wilhelm},

journal = {IEEE Robotics and Automation Letters},

title = {CNN-based Lidar Point Cloud De-Noising in Adverse Weather},

year = {2020},

keywords = {Semantic Scene Understanding;Visual Learning;Computer Vision for Transportation},

doi = {10.1109/LRA.2020.2972865},

ISSN = {2377-3774}

}

Danksagung

Diese Arbeiten wurden von der Europäischen Union im Rahmen des H2020 ECSEL-Programms als Teil des DENSE-Projekts, Vertragsnummer 692449, finanziert.

Des Weiteren möchten wir Cerema für das Bereitstellen Ihrer Nebelkammer und Unterstützung der Messungen in kontrollierten Wetterbedingungen danken. Mehr Informationen zur Nebelkammer können hier gefunden werden.

Kontakt

Feedback? Fragen? Probleme rund um/mit den Datensätzen? Kontaktieren Sie uns!

- Werner Ritter, werner.r.ritter(at)daimler.com

- Tobias Gruber, tobias.gruber(at)daimler.com

- Mario Bijelic, mario.bijelic(at)daimler.com

- Felix Heide, felix.heide(at)algolux.com